Spis treści

Narzędzia Web Scraping Tools służą do wydobywania informacji i danych z określonej witryny. Jest to proces pobierania, analizowania i organizowania danych ze stron internetowych, z których pobierasz dane.

Polega na napisaniu skryptu lub programu do interakcji z kodem HTML witryny internetowej, pobierania określonych fragmentów danych, a następnie przechowywania lub przetwarzania tych danych w różnych celach.

Narzędzia Web Scraping są często wykorzystywane do zbierania czasochłonnych danych, które można wykorzystać do różnych celów, takich jak eksploracja danych, analiza, porównywanie cen, badania, agregacja treści, monitorowanie zmian na stronach internetowych itp.

Poniżej wymieniono 7 najlepszych narzędzi do skrobania stron internetowych w 2024 r.:

1. Jasne dane

Bright Data, będąc oprogramowaniem do skrobania stron internetowych, odpowiada za wydobywanie danych za pomocą swoich botów, a także zapewnia wymagane bezpieczeństwo i prywatność. Jest to jedno z najlepszych tego typu programów, które jest pierwszym wyborem dla użytkowników.

Ekstrakcja danych: To oprogramowanie do skrobania zapewnia płynniejszą ekstrakcję danych bez żadnych komplikacji i zbiera dane z różnych źródeł.

Wiele formatów: Wyodrębnione dane i informacje są uporządkowane w różnych formatach, aby kategoryzować i uczynić je wygodnymi dla użytkowników. Formaty wahają się od arkuszy kalkulacyjnych do. CSV.

Analityka internetowa: Oprogramowanie zapewnia zestaw narzędzi do analizy strony internetowej w celu optymalizacji doświadczeń użytkowników, a także filtruje dla nich przydatne strony internetowe.

Integracja: Bright Data pozwala użytkownikom na integrację różnych i wielu serwerów proxy, takich jak SwitchyOmega Proxy, MoreLogin, AdsPower Proxy, Undetectable itp. Z jego oprogramowaniem w celu zwiększenia możliwości skrobania stron internetowych. Funkcja integracji pomaga użytkownikom efektywniej uzyskiwać dostęp do większej liczby linków, skryptów i obrazów oraz gromadzić przydatne dane.

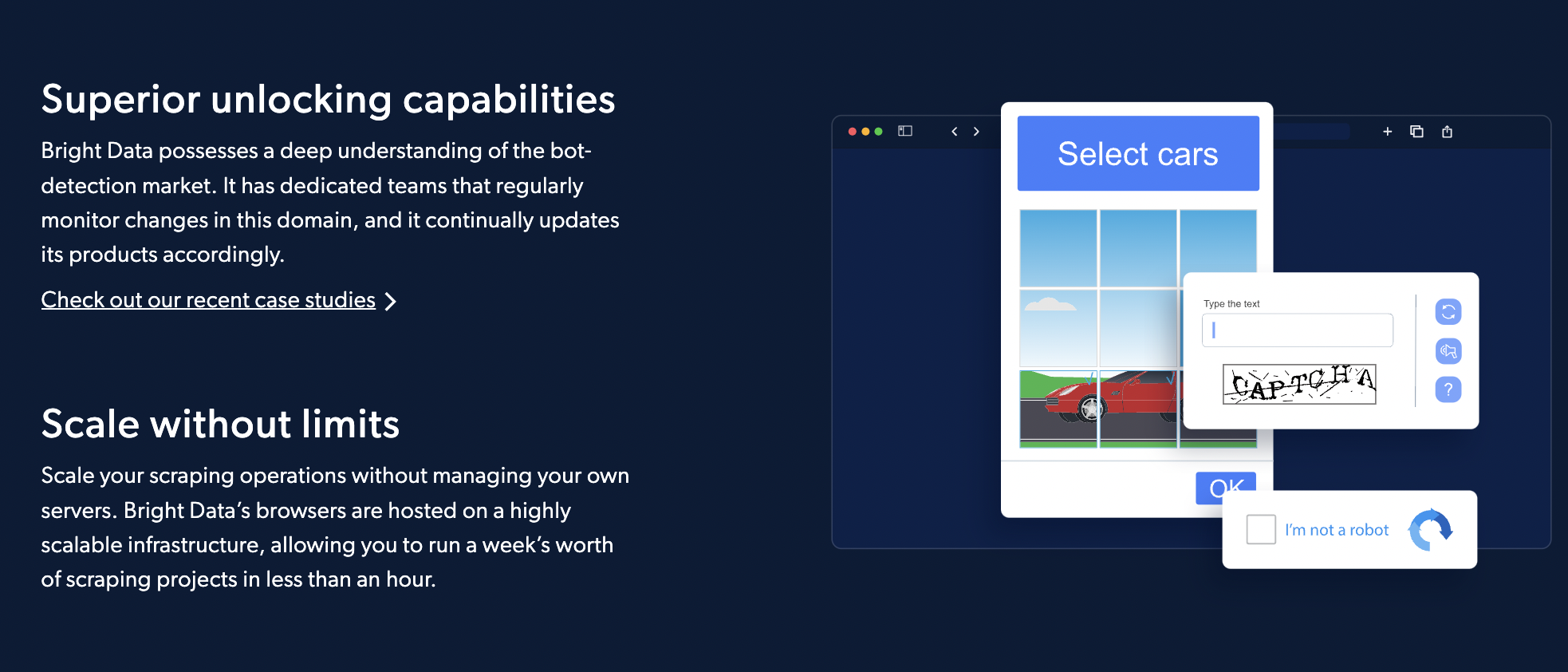

Skrobanie API przeglądarki: Jest to pomocne w blokowaniu strony internetowej; automatycznie omija blokowanie i rozwiązuje kontrole CAPTCHA i bezpieczeństwa. Jest to nie tylko pomocne w łatwiejszym skrobaniu sieci, ale także pomaga użytkownikom zaoszczędzić koszty i czas. Ta funkcja Bright Data samodzielnie zarządza odblokowaniem wymaganych stron internetowych, oszczędzając użytkownikom dodatkowej pracy.

#5 kluczowych cech, które sprawiają, że Jasne dane nr 1

1. Bright Data Scraping Browser jest łatwy w użyciu, także dla początkujących.

2. Bright Data Web Unlocker ma wbudowane iw pełni automatyczne możliwości odblokowywania.

3. Mają 100% skuteczność, to niezwykłe.

4. Dostarczają wyniki w CSV, HTML, JSON

5. Zapewniają ponad 72 miliony mieszkaniowych adresów IP typu real-peer.

Plusy i minusy jasnych danych

ZALETY

- Firma Bright Data udostępnia przewodnik użytkownika na swojej oficjalnej stronie internetowej lub w aplikacji, aby pomóc początkującym na każdym etapie.

- Jest kompatybilny z Playwright (Python), (Node.js) i Selenium

- Dostępny jest 7-dniowy bezpłatny okres próbny + 50% zniżki

- Możesz łatwo usuwać dane internetowe z dowolnego języka, kraju lub urządzenia.

- Posiada różne narzędzia do odblokowywania stron internetowych i omijania różnych programów anty-odblokowujących

Wady

- Dla niektórych użytkowników może to być stosunkowo drogie.

- Jest dostępny tylko w 8 językach, co ogranicza go do określonego języka.

Wycena jasnych danych

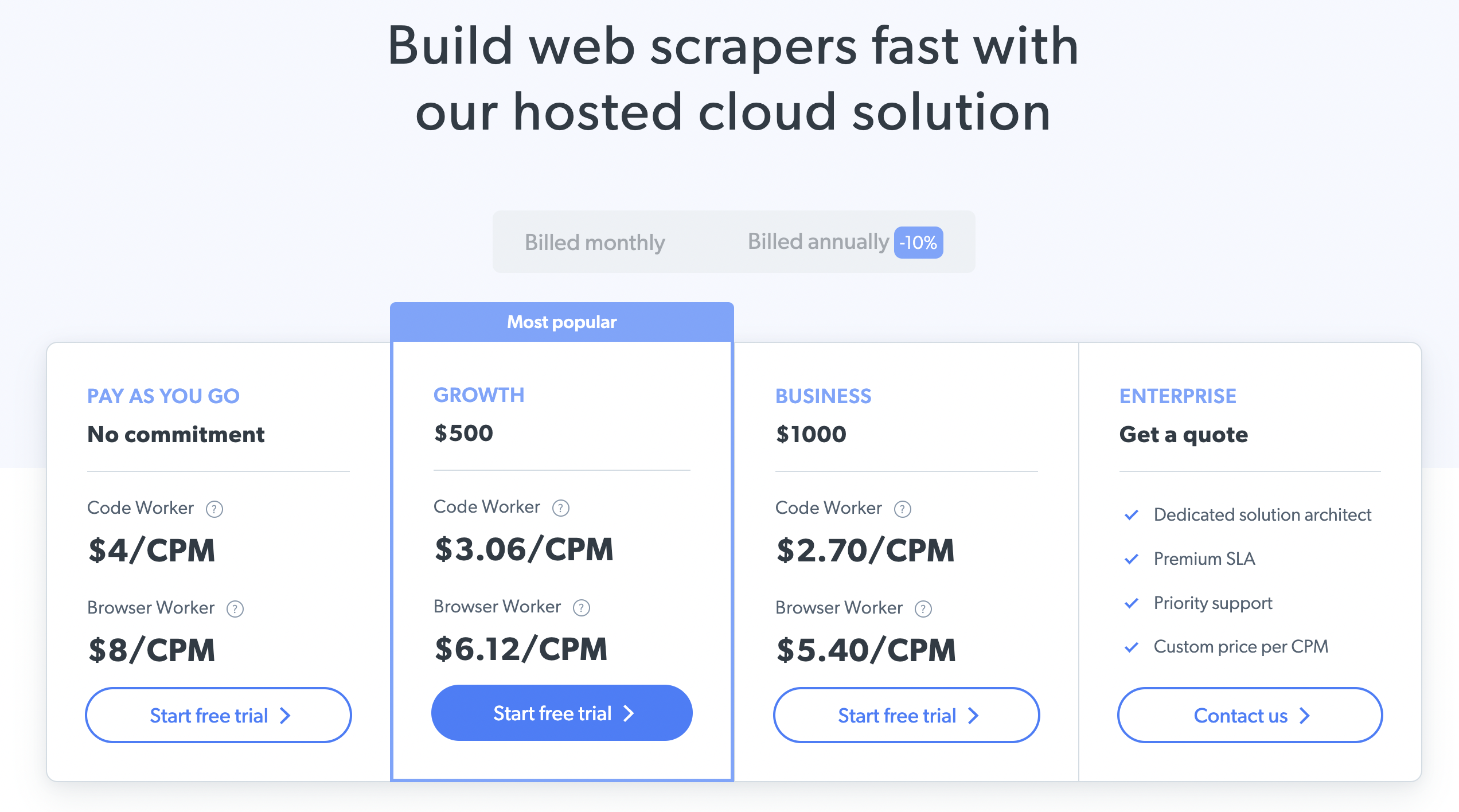

Ma dla Ciebie 4 różne plany cenowe, dzięki czemu możesz wybrać najlepszy zgodnie ze swoim modelem biznesowym lub wymaganiami.

- Płać na bieżąco: Cena zaczyna się od 4 USD/CPM

- Plan rozwoju: Będzie Cię to kosztować 500 USD (3.06 USD/CPM)

- Plan biznesowy: Ten plan jest przeznaczony dla właścicieli dużych firm, kosztuje 1000 USD (2.70 USD/CPM)

- Plan dla przedsiębiorstw: W tym celu należy skontaktować się z zespołem Bright Data, aby uzyskać wycenę.

Diffbot

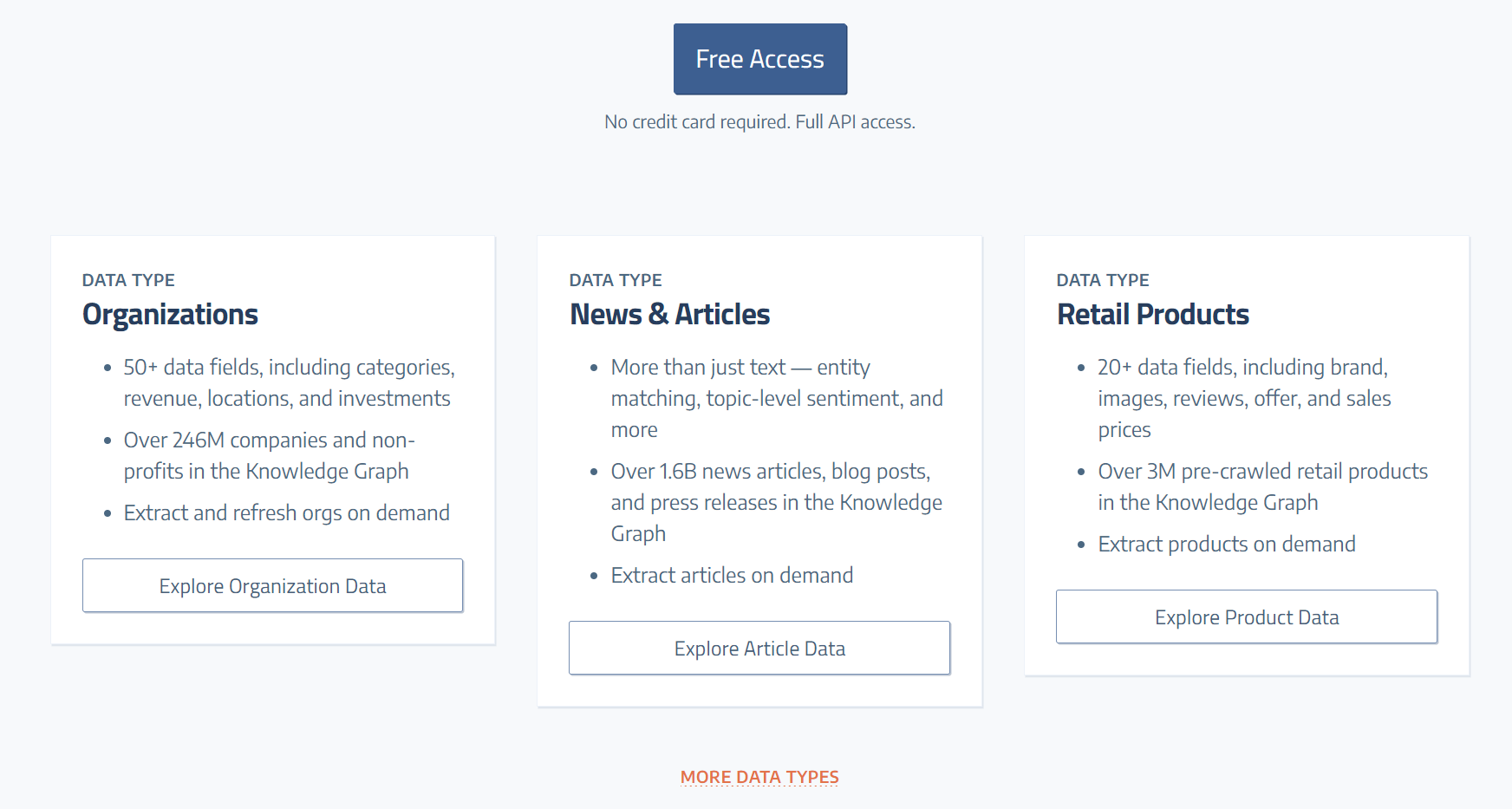

Diffbot to narzędzie do skrobania stron internetowych, które służy do wydobywania lub gromadzenia danych ze strony internetowej za pomocą sztucznej inteligencji.

Weryfikacja leadów: narzędzie do skrobania stron internetowych, Diffbot, obsługuje weryfikację potencjalnych klientów lub weryfikację treści wysokiej jakości. Zapewnia, że zbiera dane, które są przydatne dla użytkowników i może dalej porządkować zebrane dane.

Narzędzia zarządzania: Zapewnia narzędzia do zarządzania wyodrębnionymi danymi, dzięki czemu użytkownicy nie muszą martwić się o zarządzanie danymi w kategoriach. Zapewnia również narzędzie do zarządzania budżetem, aby użytkownicy nie napotykali żadnych komplikacji podczas korzystania z oprogramowania.

Import i eksport: Oprogramowanie umożliwia importowanie i eksportowanie danych oraz ustrukturyzowanych informacji na dowolną inną platformę. Umożliwia integrację z innymi aplikacjami, aby zapewnić użytkownikom możliwość analizowania danych i odpowiedniego ich wykorzystania.

Automatyzacja: Diffbot ma funkcje automatyzacji, które samodzielnie wyodrębniają, kategoryzują i porządkują wyodrębnione dane, nie pozwalając użytkownikom na napięcie z tego powodu. Automatycznie kategoryzuje przydatne i najnowsze dane oraz ułatwia użytkownikom proces.

Plusy i minusy Diffbota

ZALETY

- Pomaga użytkownikom zaoszczędzić czas na budowaniu własnego systemu skrobania sieci.

- Zbieraj dokładne i szczegółowe informacje ze stron internetowych.

- W razie potrzeby zapewniana jest pomoc w obsłudze oprogramowania.

- Dostępna jest bezpłatna wersja próbna, aby upewnić się, że jest warta.

Wady

- Nie jest dostępny dla systemu Windows.

- Może być złożony dla początkujących.

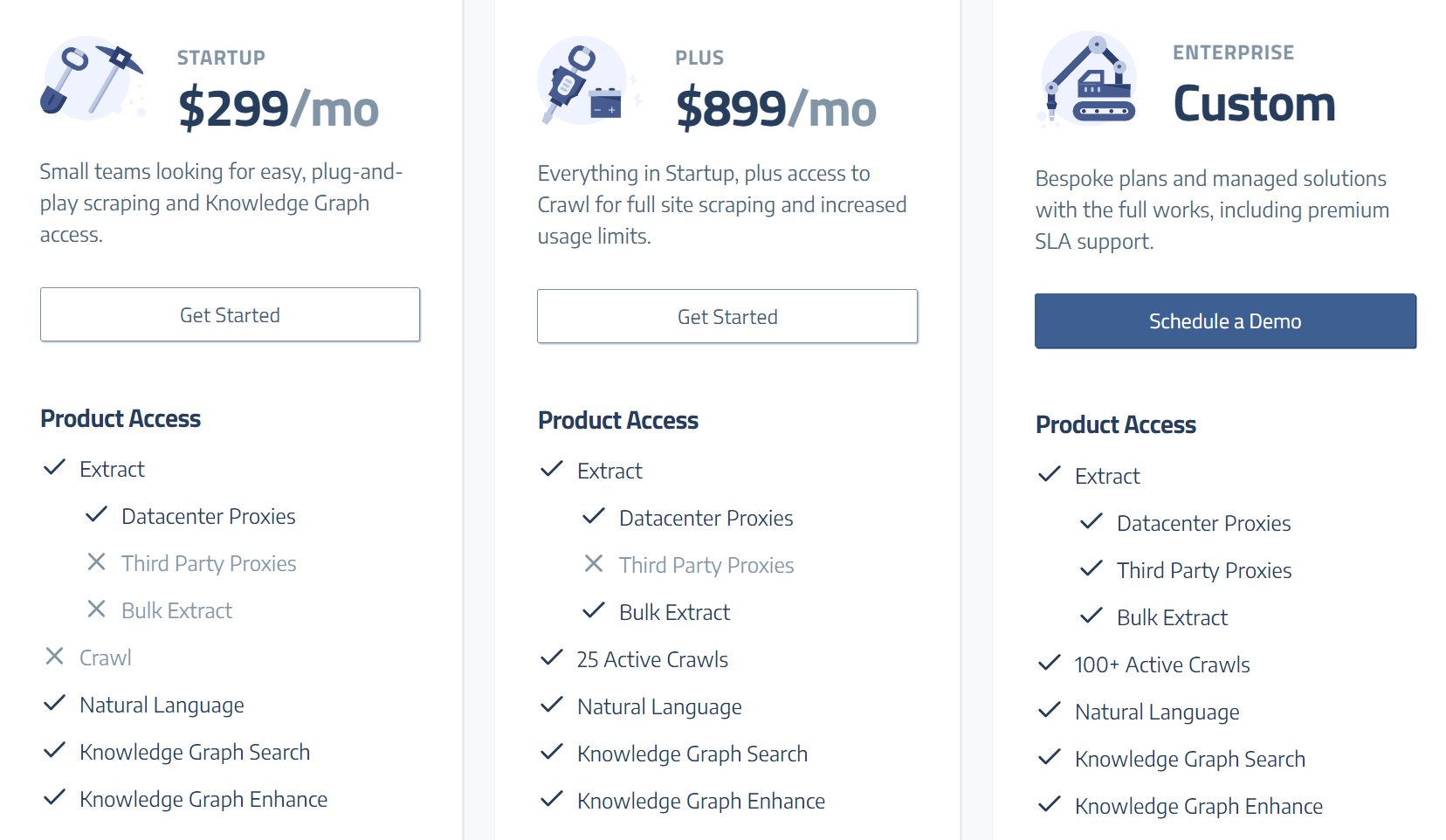

Plan cenowy Diffbota

Plan startowy Diffbot jest dostępny za 299 USD miesięcznie, a plan plus jest dostępny za 899 USD miesięcznie.

Oxylaby

Oxylabs to jedno z najbardziej użytecznych i niezawodnych programów do skrobania stron internetowych, które świadczy usługi dla wielu branż i platform elektronicznych.

Zwykle odpowiada za etyczne pozyskiwanie danych i pomaga swoim użytkownikom w ich biznesach.

Dostępność wielu serwerów proxy: Oprogramowanie zapewnia szeroką gamę serwerów proxy, takich jak serwery proxy dla mieszkań, serwerów proxy dla współdzielonych danych i serwerów proxy dedykowanych centrów danych, do przeprowadzania badań rynkowych oraz ochrony marki i poczty e-mail oraz monitorowania recenzji i cen.

Dostępność wielu serwerów proxy pomaga systemowi w automatycznej rotacji serwerów proxy w celu zapewnienia bezpieczeństwa użytkowników.

Odblokowywanie: Oxylabs posiada w swoim oprogramowaniu funkcję odblokowywania sieci, która najlepiej nadaje się do „Skrobania nieruchomości”. Oszukuje zaawansowane systemy zapobiegające skrobaniu i wydobywa wiarygodne dane dla użytkowników, nie stwarzając żadnych problemów dla użytkowników. Może również wydobywać dane ze stron internetowych zablokowanych przez IP, odblokowując ograniczenia geograficzne, do których nie można uzyskać dostępu w inny sposób.

Łatwa integracja: Jej usługi proxy można łatwo zintegrować z istniejącymi aplikacjami i projektami, aby uzyskać dostęp do danych z pożądanych systemów i stron internetowych. Zapewniają również możliwość integracji proxy z różnymi narzędziami do skrobania stron internetowych, aby ekstrakcja była łatwiejsza i prostsza.

Szeroki i globalny zasięg proxy: Zapewnia różne serwery proxy, do których można uzyskać dostęp globalnie, i pomaga uzyskać dostęp do informacji na całym świecie, oszukując blokady IP systemów lub stron internetowych. Pozwala na dostęp do danych niezależnie od kraju, miasta i kontynentu.

Plusy i minusy Oxylabs

ZALETY

- Z jej usług można korzystać w wielu gałęziach przemysłu

- Obsługuje automatyczną filtrację i rotację

- Sesje mogą być zarządzane przez użytkowników w celu gromadzenia wiarygodnych danych

- Dostępne różne serwery proxy dla płynniejszej ekstrakcji danych

- Może ominąć różne blokady adresów IP i uzyskać dostęp do przydatnych informacji

Wady

- Dostęp do narzędzi premium może być stosunkowo kosztowny dla niektórych użytkowników

- Mniejsza kontrola nad dostępem do danych

- Dla niektórych użytkowników może to być skomplikowane, ponieważ wymaga dobrej znajomości instalacji

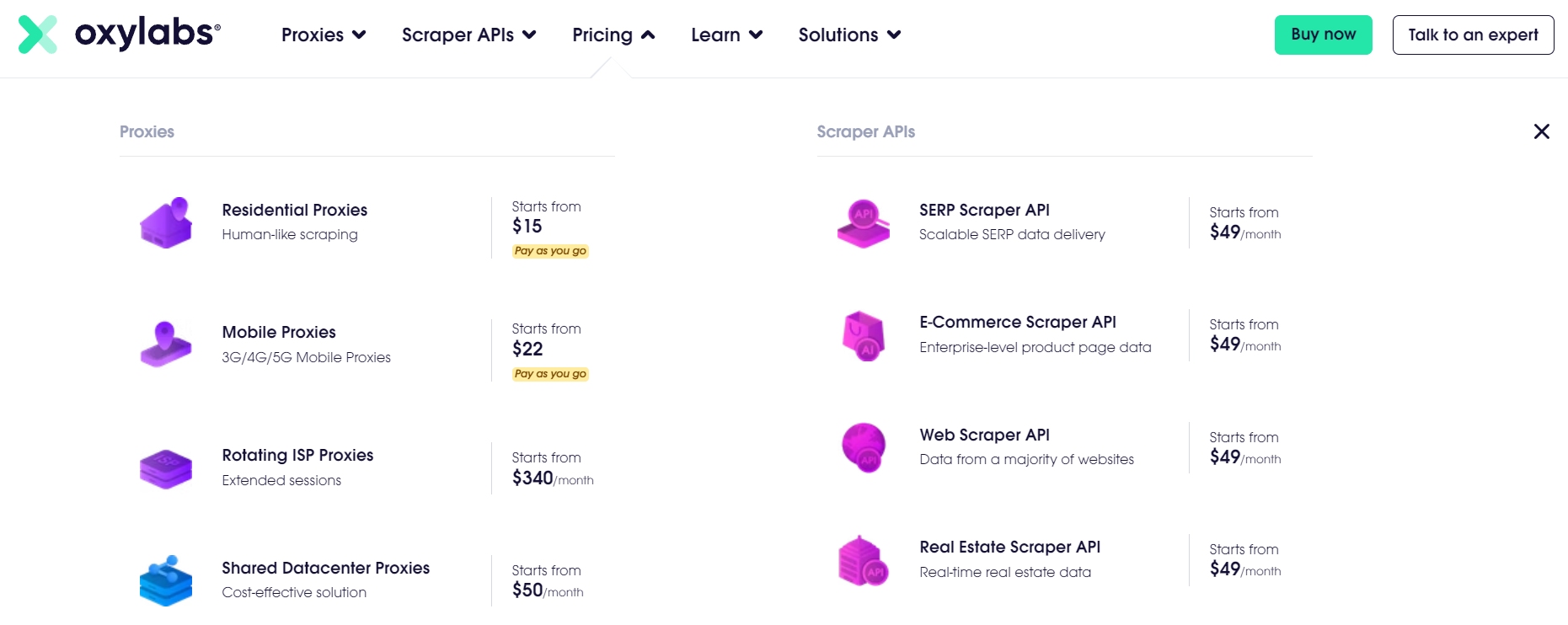

Plan cenowy Oxylabs

Regularna

- Płać na bieżąco – 15 USD/GB

- Starter – 300 USD/miesiąc

- Zaawansowany – 600 USD/miesiąc

- Premia – 800 USD

Enterprise

- Venture - 1,750 $ / miesiąc

- Biznes - 3,000 USD / miesiąc

- Korporacyjny – 4,000 USD/miesiąc

- Custom+ – zaczyna się od 5,000 $ miesięcznie

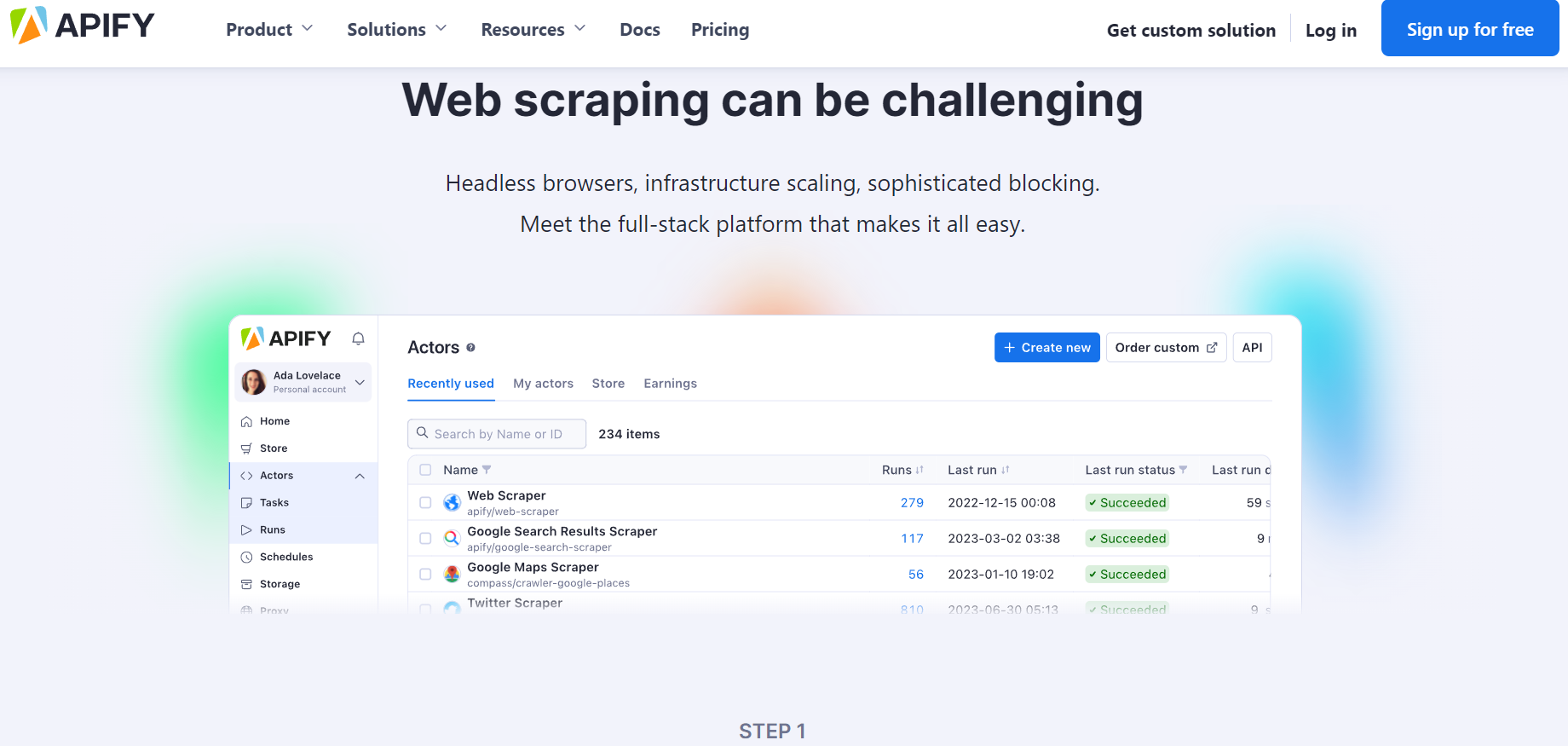

Apify

Apify to oprogramowanie do skrobania stron internetowych odpowiedzialne za wydobywanie danych ze stron internetowych dla użytkowników, które mogą dodatkowo pomóc im w ich biznesach. Wdraża robota sieciowego, aby uzyskać dostęp do witryny i zebrać informacje.

Rozwiązanie do przechowywania danych: Apify umożliwia użytkownikom korzystanie z magazynu danych, dzięki któremu mogą zapisywać zeskrobane dane i odpowiednio nimi zarządzać. Jest łatwy w użyciu i umożliwia użytkownikom zapisywanie danych w przydatny sposób do wykorzystania w przyszłości.

Rotacja proxy: Zapewnia funkcję rotacji serwerów proxy dostępnych na platformie, która dodatkowo odblokowuje blokowanie adresów IP i dostęp do zastrzeżonych danych stron internetowych.

Apify Aktorzy: Są to narzędzia do skrobania stron internetowych, które można łatwo zintegrować. Działa bez żadnego niestandardowego kodu, co przyspiesza wykonanie zadania. Są one wstępnie zbudowane i mogą być ponownie wykorzystane do zwykłego skrobania stron internetowych.

Personalizacja: Apify umożliwia użytkownikom dostosowywanie gotowych aktorów do ich potrzeb. Można tworzyć niestandardowych aktorów do wykonywania pożądanych zadań.

Automatyzacja: Jedną z jego ważnych cech jest automatyzacja, która zapewnia automatyzację powtarzalnych zadań. Ta funkcja oszczędza wysiłek i czas programisty oraz pomaga w automatycznej nawigacji po różnych stronach internetowych w celu usunięcia przydatnych danych.

Społeczność Apify: Zapewnia użytkownikom platformę do szukania pomocy i wsparcia, a Apify zapewnia rozwiązania ich zapytań i problemów związanych z każdym powiązanym projektem.

Plusy i minusy Apify

ZALETY

- Umożliwia dostosowanie do trudnych zadań związanych ze skrobaniem

- Umożliwia użytkownikom ominięcie systemu blokowania adresów IP w celu usunięcia wiarygodnych danych

- Przyjazny dla użytkownika interfejs oprogramowania sprawia, że jest łatwy w użyciu nawet dla początkujących

- Umożliwia łatwą integrację z innymi platformami w celu lepszego funkcjonowania

- Dostępna jest bezpłatna wersja próbna

Wady

- Koszt może być wyższy w zależności od usług

- Wymaga konserwacji przy ciągłych zmianach w oprogramowaniu

- Nie składa się z żadnego narzędzia ani funkcji do skrobania aplikacji mobilnych

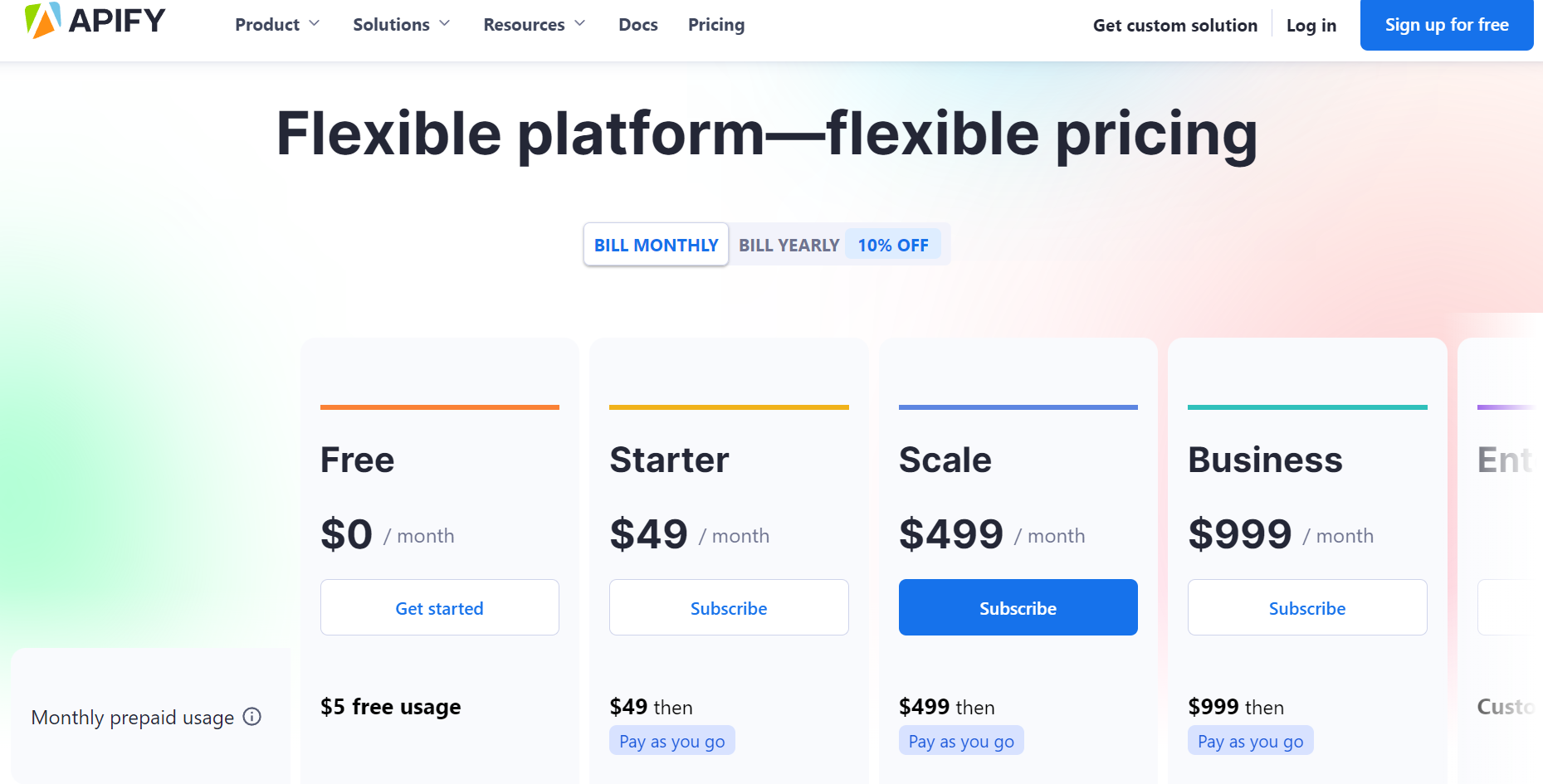

Plan cenowy Apify

Rozliczenia miesięczne

- Starter – 49 USD/miesiąc

- Skala – 499 USD / miesiąc

- Biznes - 999 USD / miesiąc

- Przedsiębiorstwo – Niestandardowe

Rozliczenia roczne

- Starter – 44 USD/miesiąc

- Skala – 449 USD / miesiąc

- Biznes - 899 USD / miesiąc

- Przedsiębiorstwo – Niestandardowe

SkrobaniePszczoła

Jest to potężne oprogramowanie do skrobania stron internetowych do zbierania informacji ze stron internetowych i zarządzania nimi. Zapewnia również wydajne narzędzia i rozwiązania do wydobywania danych przydatnych dla użytkowników, co czyni go wysokiej jakości oprogramowaniem do zbierania danych.

Renderowanie JavaScript: Pozwala użytkownikom uruchamiać niestandardowy kod JavaScript na dowolnej pożądanej stronie internetowej, na której chcą zeskrobać i pobrać informacje.

Kierowanie geograficzne: Pomaga użytkownikom uzyskać dostęp do stron internetowych i danych dostępnych na stronach internetowych poprzez kierowanie na dowolne określone położenie geograficzne, które może być przydatne dla użytkowników.

Zrzuty ekranu: Umożliwia użytkownikom przechwytywanie zrzutów ekranu ekranu strony internetowej, którą chcą zeskrobać. Pomaga zbierać informacje bez kodu HTML, co upraszcza użytkownikom.

Zautomatyzowane zarządzanie: Jedna z jego funkcji chroni użytkowników przed spędzaniem dni na szukaniu odpowiedniego dostawcy proxy. Automatycznie zarządza danymi i przeglądarkami, dzięki czemu przeglądanie sieci jest mniej skomplikowane dla użytkowników.

Personalizacja: Pozwala użytkownikom dostosowywać silniki do skrobania stron internetowych bez żadnego kodowania. Oszczędza czas użytkowników, unikając kodowania i umożliwiając dostosowywanie.

Plusy i minusy ScrapingBee

ZALETY

- Umożliwia masowe skrobanie w celu jednoczesnego wyodrębnienia danych z różnych stron internetowych

- Szyfrowanie SSL zapewnia prywatność danych użytkowników

- Obsługuje łatwą integrację skrobaka API z innymi platformami

- Zapewnia ciągłą ekstrakcję danych, która jest niezawodna i użyteczna

Wady

- Pozwala na ograniczoną personalizację

- Nie jest tak niezawodny w przypadku skrobania offline

Plan cenowy ScrapingBee

- Wolny strzelec – 49 USD miesięcznie

- Startup – 99 USD/miesiąc

- Biznes - 249 USD / miesiąc

- Biznes+ – 599 USD+/miesiąc

ParseHub

ParseHub to jedno z najbardziej niezawodnych programów do skrobania stron internetowych, które oferuje różne funkcje i narzędzia do wydobywania danych z dowolnej witryny bez żadnych komplikacji.

Poniżej wymieniono funkcje, zalety i wady oraz plan cenowy ParseHub-

Wiele nawigacji: Ta platforma oferuje nawigację na wielu stronach internetowych jednocześnie, co oszczędza czas użytkowników, unikając skrobania poszczególnych witryn.

Analitycy i konsultanci: Posiada analityków i konsultantów do analizy przydatnych danych dla branż, marketingu i konkurencji. Za pomocą zaawansowanych narzędzi analizuje dane i zapewnia użytkownikom dokładne statystyki rynkowe oraz lepszy wgląd w biznes.

Niestandardowe interfejsy API: Oferuje niestandardowe interfejsy API do skrobania sieci, które oszczędzają użytkownikom wysiłku związanego z tworzeniem oprogramowania do skrobania od podstaw. Pomaga użytkownikom dostosować, a następnie zeskrobać potrzebne dane z dowolnej witryny.

Wizualizacja: ScrapingBee wyodrębnia kategorie i integruje dane z Tableau, a następnie umieszcza je w wizualizacji.

Plusy i minusy ParseHub

ZALETY

- Zapewnia różne pomoce i rozwiązania do skrobania dowolnej strony internetowej

- Posiada narzędzia do czyszczenia zeskrobanych danych i zapewnia niezawodność i dokładność wyodrębnionych danych

- Oferuje zaplanowane skrobanie danych

- Posiada przyjazny dla użytkownika interfejs, który zapewnia płynniejsze działanie

Wady

- Ma ograniczoną liczbę skrobania stron i trzeba zaktualizować plan, aby uzyskać więcej skrobania

- W przypadku ekstrakcji złożonych danych użytkownik może potrzebować wcześniejszej wiedzy technicznej

Plan cenowy ParseHub

- Standard - 189 USD / miesiąc

- Professional - 599 $ / miesiąc

- ParseHub — niestandardowy/miesiąc

Skrobak API

Jest to potężne oprogramowanie do skrobania stron internetowych, które oferuje zestawy narzędzi i funkcje do odbierania danych i kodów HTML z różnych stron internetowych za pomocą wywołań API.

Personalizacja nagłówków: Pozwala użytkownikom dostosować nagłówki HTTP, co sprawia, że proces ekstrakcji danych ze stron internetowych jest elastyczny.

Kierowanie geograficzne: Ta funkcja ScraperAPI zapewnia użytkownikom możliwość zgarniania danych na całym świecie. Pozwala użytkownikom ustawić preferencje dotyczące lokalizacji, a następnie pobierać informacje ze stron dostępnych lub znajdujących się w tej lokalizacji.

Omijanie CAPTCHA: Jedną z jego funkcji jest pomijanie CAPTCHA, które pomaga użytkownikom ominąć CAPTCHA poprzez wywołania API, a ponadto zapewnia płynniejsze i nieprzerwane pobieranie danych.

Rotacyjny pełnomocnik: Pomaga użytkownikom nawiązywać nowe połączenia z różnymi serwerami proxy zgodnie z wymaganiami i oszczędza czas i wysiłek.

Plusy i minusy ScraperAPI

ZALETY

- Jego boty i sztuczna inteligencja zbierają najnowsze dane dostępne w witrynie dla użytkowników, ponieważ ma funkcję rotacji proxy.

- Zapewnia profesjonalne wsparcie użytkownikom w razie potrzeby; mają opublikowane samouczki i rozwiązania dla różnych narzędzi i funkcji.

- Jego przyjazny dla użytkownika interfejs sprawia, że jest łatwy w użyciu nawet dla początkujących.

- Jest przyjazny dla budżetu, a jego plany są również przyjazne dla kieszeni.

Wady

- Ma swoje ograniczenia podczas kierowania na określone lokalizacje geograficzne w celu skrobania.

- Jeśli użytkownicy nie wykorzystają kredytów dostępnych w danym miesiącu, nie mogą zostać przeniesione na kolejny miesiąc.

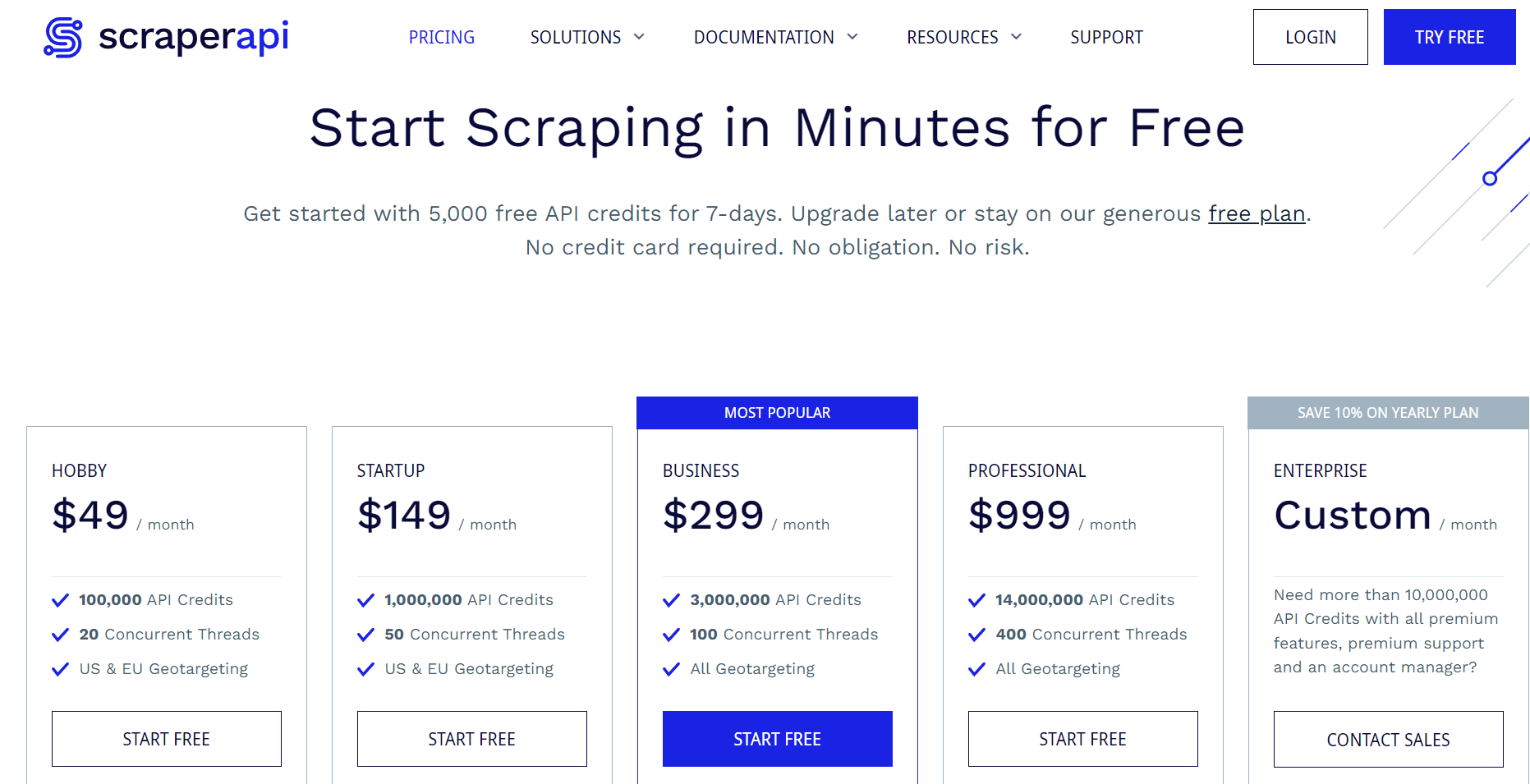

Plan cenowy ScraperAPI

Dla początkujących zapewnia 5,000 darmowych kredytów API, które są ważne przez 7 dni. Oprócz darmowych kredytów ma 5 różnych planów abonamentowych w zależności od potrzeb użytkowników lub rodzaju działalności.

Jego plan „Hobby” kosztuje 49 USD miesięcznie, co zapewnia użytkownikom 100,000 149 kredytów API. Jeśli użytkownicy mają start-up, mogą wybrać plan „Start Up”, który kosztuje XNUMX USD miesięcznie.

Użytkownicy mogą wybrać plan „Biznesowy” dla swojej firmy, który kosztuje 299 USD miesięcznie i zapewnia 3,000,000 XNUMX XNUMX kredytów API.

Ma również plan „Professional”, który kosztuje 999 USD miesięcznie i zapewnia ponad 10,000,000 XNUMX XNUMX kredytów API. Jeśli te plany nadal nie są odpowiednie dla potrzeb użytkownika, może on wybrać plan „Enterprise”, który można dostosować zgodnie z jego budżetem i potrzebami kredytowymi API.

Te 5 kroków obejmuje skrobanie sieci

1. Rozpoczyna pobieranie witryny sieci Web lub stron sieci Web, wysyłając żądanie HTTP do serwera witryny docelowej w celu pobrania zawartości HTML określonej strony internetowej.

2. Po pobraniu danych HTML następnym krokiem jest ich przeanalizowanie w celu wyodrębnienia żądanych danych za pomocą bibliotek. Biblioteki te umożliwiają nawigację i manipulację strukturą HTML.

3. Następnie musisz zidentyfikować i wybrać wymagane elementy HTML, takie jak tagi, klasy i identyfikatory.

4. Wyodrębnianie odpowiednich danych, takich jak tekst, atrybuty, linki, obrazy lub wszelkie inne informacje obecne w kodzie HTML.

5. Po wyodrębnieniu danych można je zapisać w lokalnym pliku lub bazie danych albo użyć do dalszych obliczeń.

Najczęściej zadawane pytania

Oprogramowanie do skrobania stron internetowych umożliwia oprogramowaniu zgarnianie lub wyodrębnianie danych z dowolnej konkretnej witryny za pomocą dostarczonych przez nie narzędzi i funkcji.

Alternatywami dla ScrapingBee mogą być Scraping API, ParseHub, Oxylabs, Brightdata itp.

Tak, bezpłatna wersja próbna jest dostępna w Scraping API przez 7 dni.